Natural Language Processing – Sprache verstehen, Wissen nutzbar machen

Was uns antreibt

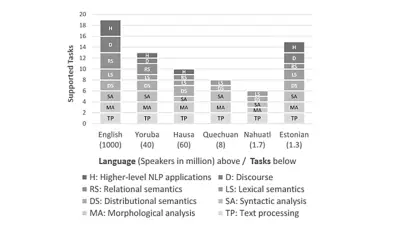

Die Verarbeitung natürlicher Sprache (Natural Language Processing, NLP) steht im Zentrum vieler aktueller KI-Entwicklungen – darunter auch große Sprachmodelle wie GPT-3 oder BERT. Während diese Methoden für die Analyse von allgemeinen Texten erstaunlich gut funktionieren, sind sie deutlich weniger zuverlässig, wenn es um die Analyse spezieller und textärmerer Inhalte geht, wie sie in vielen Fachgebieten bei Bosch vorkommen.

Unser Ansatz

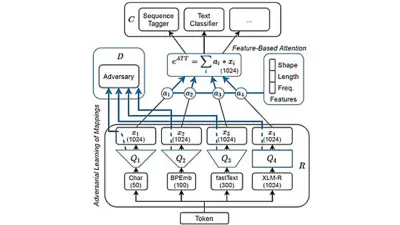

Das Ziel ist ein skalierbares NLP im heterogenen industriellen Kontext bei Bosch. Die zentrale Herausforderung besteht in sogenannten Low-Resource-Settings – also Szenarien, in denen nur sehr wenig (annotierte) Trainingsdaten vorliegen. Dafür arbeiten wir an Themen wie: Robuste Repräsentationen für Eingabedaten

- Transfer Learning zwischen verwandten Aufgaben oder Domänen

- Anpassung von Deep-Learning-Modellen an spezifische Anforderungen

- Erstellung individueller Trainings- und Evaluationsdaten

Anwendungsfelder

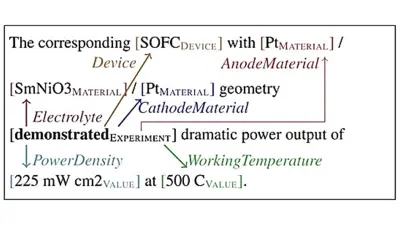

Ein Großteil des verfügbaren Wissens liegt in unstrukturierten Textdaten, die in unterschiedlichen Formen vorliegen, z. B. in wissenschaftlichen Publikationen, Webseiten oder internen Dokumenten. NLP ist die Schlüsseltechnologie, um dieses Wissen zu erschließen und für Bosch-Produkte und -Services nutzbar zu machen – etwa durch:

- Wissensextraktion aus Texten

- Abrufen von Wissen entsprechend der Nutzerbedürfnisse

- Umwandlung von Text in Wissen und von Wissen in Mehrwert

Unsere Methoden sind besonders hilfreich für Geschäftsbereiche, die große Mengen an Textdaten direkt analysieren oder verstehen müssen, oder in Szenarien, in denen die semantische Struktur und Bedeutung der hinter Textbeschreibungen liegenden Objekte erfasst werden sollen. Beispiele für Einsatzbereiche sind die Materialwissenschaft und die Automobilbranche.